데이터실무

DA, SQL, DB보안 등 실무자를 위한 위한 DB기술 바이블!

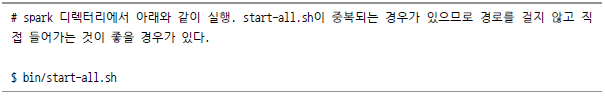

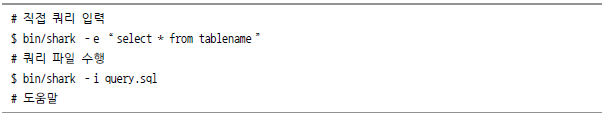

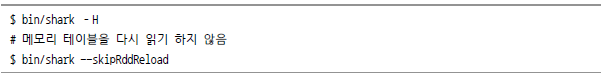

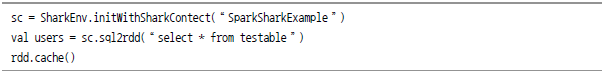

이번 절에서 다룰 내용은 샤크(Shark, Spark SQL)다. 굳이 샤크와 Spark SQL을 병기한 이유는 원고가 작성되는 시점에서 ‘샤크에 대한 개발은 중지하고 Spark SQL에 개발 리소스를 할당하겠다’는 발표가 있었기 때문이다. 다음에 다루겠지만 샤크는 Spark 엔진 위에서 돌던 하이브 기반 프로젝트다. 하이브의 변경 사항을 매번 반영하기엔 너무 비효율적이라 아예 Spark SQL이라고 하는 새로운 프로젝트를 만들기 시작했고, 샤크의 대부분의 기능을 승계해서 넣기로 했다. 그러나 아직까지 샤크를 쓰는 곳이 많고 Spark SQL이 완전히 안정화된 상태가 아니라서 여기서는 둘 다 언급한다. 이외에도 Hive Jira에(아파치 프로젝트들이 대부분 사용하는 이슈트레커) 하이브에서 Spark 엔진을 사용할 수 있도록 하는 ticket이 진행되고 있다(HIVE-7292). 이것은 아직 개발이 많이 남아있기 때문에 따로 언급하지는 않지만 내년쯤에는 다시 이슈가 될 수 있을 것이다. 샤크(Shark)는 Spark의 Sark와 하이브의 H를 합쳐서 만든 단어로 Spark 엔진 위에서 하이브가 동작하도록 만든 프로그램이다(Spark에 대해서는 ‘3단원 3장 스트트리밍 데이터 처리’에서 좀 더 자세히 소개한다). SQL-On-Hadoop과 같이 하이브의 단점을 개선한 샤크의 특징은 다음과 같다. [그림 Ⅲ-2-34] 샤크의 메모리 활용 가장 큰 특징 중 하나는 Spark 엔진을 사용함으로써 메모리를 최대한 많이 활용한다는 점이다. 이 방식을 사용함에 따라서 반복 작업은 수 배에서 수십 배 빨리 처리가 가능하고, 인터랙티브한 쿼리도 지원할 수 있게 됐다. 단, 너무 큰 데이터는 아주 높은 성능을 기대하기 어려울 수 있고, 하이브에 비해서 메모리 관리를 더 잘해 줘야 한다. [그림 Ⅲ-2-35] 하이브 구성도 [그림 Ⅲ-2-36] 샤크 구성도 위 그림을 보면, 하이브에서 변경된 부분을 파악하기 쉽다. 먼저 하이브와 똑같이 HDFS에서 데이터를 읽어와서 작업을 수행하고, 맵리듀스 대신 Spark를 엔진으로 처리하도록 한다. Metastore는 그대로 사용하되 클라이언트는 Optimizer와 Cache, Plan 등을 수정하고 나머지는 거의 그대로 사용했다. Spark 위에서 작동하는 프로그램들은 로컬, 클러스터, EC2, Yachyon 등 여러 가지 환경에서 구동이 가능하다. 여기서는 가장 일반적인 로컬 모드와 Yarn 모드에 대해 알아 보겠다. 샤크는 Spark를 엔진으로 사용하고 있다고 소개했다. Spark는(샤크 포함) 스칼라라는 언어로 작성돼 있다. 그렇기 때문에 이번뿐만 아니라 Spark 관련 프로그램을 사용할 때는 이전에 설치했던 환경에서 추가로 스칼라가 설치돼 있어야 한다. 그 밖에 프로그램들은 대부분 압축만 풀고 본인의 설정에 맞게 환경설정 파일만 수정해 주면 된다. 그러나 로컬 모드는 Spark의 장점을 확인하기 힘들어서 사용할 일이 거의 없으므로 간단히 테스트해 보고 클러스터 모드로 넘어가 보자. 클러스터 모드는 로컬 모드 설치에서 Spark만 추가로 설치해 주고, 일부 설정파일만 변경해 주면 된다. 만약 다운로드가 되지 않는다면 http://archive.apache.org/dist/spark/ 에서 필요한 버전을 내려받는다. 샤크는 쿼리 파서로 하이브 라이브러리를 사용하기 때문에 샤크의 사용법은 몇 가지를 제외하고 하이브와 동일하다. 이 부분에서는 하이브와 다른 사용 방법 위주로 설명하겠다. 샤크는 0.9.2버전을 끝으로 더 이상 개발되지 않을 예정이다. 그 대신 Spark SQL이 그 역할을 대신하는데 아직까지 완전한 버전이 아니고 보완이 필요한 상태이다. 가장 최근에 나온 1.1.0 버전에서는 일부 구현됐지만, CLI나 JDBC도 최근에 구현되었고 하이브나 기타 SQL-On-Hadoop에 비해 안정화도 많이 부족하다. 가장 눈에 띄는 부분은 성능 향상이다. [그림 Ⅲ-2-37] 샤크와 Spark SQL의 성능 차이(테스트: Databricks) 위 그림은 샤크 0.9.2 버전과 Spark SQL의 성능 차이를 TPC-DS Benchmark를 이용해 비교한 것이다. SparkSQL에서 아래와 같이 Query rewrite, Transform와 같이 최대한 빠르게 필요한 데이터를 선택하는 기법이나 Runtime Bytecode Generation과 같이 JVM 부분을 개선하는 방법을 사용했다. 샤크에서 RDD와 연동하는 부분을 잠깐 설명했는데, SparkSQL에서는 훨씬 간단하게 RDD와 연동이 되고 여러 가지 Operator를 이용할 수 있게 됐다. 이번에 실습할 내용은 스칼라로 직접 프로그래밍 하는 방식이다. Spark SQL은 아직 셀을 제공하지 않기 때문에 직접 프로그래밍 하는 방법밖에 없다(1.1.0버전에서 완벽하진 않지만 셀 기능이 추가됐다). Spark를 이용한 자세한 프로그래밍은 3장 스트리밍 데이터 처리를 참고하자. Spark Sql 프로그래밍은 스칼라, 자바, 파이썬으로 할 수 있다. 서드파티로 다른 언어도 지원하지만이 3가지 가운데 한 언어를 사용하는 것을 추천한다. Spark에서의 지원기능 차이와 간결성에 있어서 스칼라가 훨씬 좋기 때문에 스칼라를 쓰는 것이 제일 좋다. 이 책에서도 가능한 스칼라 위주로 설명할 예정이다. 책에 나오는 예제는 실습의 편리성을 위해서 Spark Committer들의 확인을 받고 Spark 공식 홈페이지(https://spark.apache.org)를 참고했다. 다른 언어로도 테스트하고 싶으면 위페이지에서 확인해 보면 된다. SparkContext는 Spark Cluster에 접근하기 위한 접점이라고 보면 된다. Spark Cluster에 접속하기 위한 정보가 포함된 Class이며, 분산 처리하기 위해서 꼭 미리 선언해 줘야 한다. 샤크에서도 잠깐 언급했듯이 테이블의 데이터를 프로그래밍으로 쉽게 조작할 수 있다. 아래의 코드는 스칼라의 Case라는 클래스를 이용해 데이터를 읽고 Person이라는 테이블을 만들고, SQL 쿼리를 수행하는 코드다. 단, 스칼라 2.10에서는 컬럼 수가 22개를 넘을 수 없으므로 주의하자. Spark SQL에서는 JSON 형태의 RDD 혹은 파일을 자동으로 스키마를 맞춰서 데이터 로드를 할 수 있다. 이때 사용되는 함수는 아래와 같다. 하이브를 사용하기 위해서는 하이브 라이브러리가 필요하다. 처음 빌드 시에 ?P hive 옵션을 통해 hive jar 파일을 만들고 각 워커 노드에 복사해 둔다. 1.1.0 버전에서는 샤크에서처럼 SparkSQL도 셀 모드를 지원한다. bin/spark-sql을 실행하면, Spark SQL Shell로 진입하게 된다. localmode로 하이브의 데이터를 읽어올 수 있다. 테이블의 데이터를 In-memory columnar format으로 캐싱할 수 있다. 자동으로 압축해서 메모리 사용을 최소화해 gc에 따른 시간 소모도 줄여서 속도를 높일 수 있다. 이 코드는 Spark 코드 내 org.apache.spark.examples.sql에 포함돼 있다. 위에서 다뤘던 내용을 포함해 전반적인 내용을 보기 좋으므로 간단히 살펴보자. SparkSQL은 Spark 안에서 가장 빨리 발전하고 있는 컴포넌트 중 하나다. 그러나 아직까지 하이브에서 지원하는 기능을 모두 지원하지는 않는다. 일반적인 SQL문이나 Operator, 심지어 UDF와 SerDes도 지원하므로 지원하지 않는 대표적인 몇 가지만 뽑아 보겠다.샤크 소개와 아키텍처

참고로 이 단원은 SQL-On-Hadoop 이후에 스트리밍 처리를 다루고 있으므로 샤크와 Spark SQL을 먼저 소개한다. 하지만 Spark와 스칼라라는 프로그래밍에 대한 선지식이 있어야 더 이해하기 쉽다. 셀(shell)이나 SQL문 실행만 한다면 자세히는 몰라도 되지만, Spark의 강력한 기능 중 하나인 연동기능을 쓰지 못하는 것이니 미리 알아 두는 것이 좋다. Spark는 3장 스트리밍 데이터 처리에서 소개하고 있으니 Spark 부분을 먼저 읽고, 스칼라에 대한 내용은 http://goo.gl/k0merD를 통해 간단히 알아보자.

샤크

샤크 아키텍처

타조 아키텍처

![[그림 Ⅲ-2-34] 샤크의 메모리 활용](https://dataonair.or.kr/publishing/img/dbguide/bigdata_technology/324_bigdata_01.png)

그러나 모든 기능을 전부 새로 구현한 것은 아니다. 기존의 하이브의 사용자가 워낙 많고, 하이브 엔진(맵리듀스)을 제외하면 이미 성숙한 오픈소스이므로 일부만 변경작업을 하고 나머지는 하이브의 라이브러리를 그대로 이용했다.![[그림 Ⅲ-2-35] 하이브 구성도](https://dataonair.or.kr/publishing/img/dbguide/bigdata_technology/324_bigdata_02.png)

![[그림 Ⅲ-2-36] 샤크 구성도](https://dataonair.or.kr/publishing/img/dbguide/bigdata_technology/324_bigdata_03.png)

이런 아키텍처는 하이브의 사용자가 기존의 SQL을 수정하지 않고 그대로 사용가능하고, JDBC 등을 통해 연결해 놓은 프로그램이나 UDF도 수정할 필요 없이 그대로 사용한다는 장점이 있다. 그러나 하이브의 코드가 계속 변경되고 새로운 기능이 추가됨에 따라 샤크에서도 변경해야 할 작업들이 많이 발생하고, 주도적으로 개발방향을 잡기가 힘들다는 단점이 있다. 그래서 현재까지 나와 있는 샤크는 하이브의 0.11 버전의 기능까지만 커버하게 됐고(글을 쓰는 시점에 하이브는 0.13까지 나와 있다), 대신 Spark SQL이라는 이름으로 전체를 새로 개발하게 된다.

샤크 설치방법

로컬 모드 설치 방법

![]()

클러스터 모드 설치방법

![]()

샤크 사용방법

Spark SQL

Spark SQL 소개

API의 변경을 최소화 한다고 목표를 잡고 있지만, 아직까지는 상용으로 사용하기는 불안정한 측면이 있다. 다른 SQL-On-Hadoop이나 샤크를 사용하다가 안정화가 이뤄진 후에 Spark SQL로 전환하는 것이 좋다.

샤크는 Spark와 연계됐지만 상대적으로 분리된 프로젝트였다. 하지만 Spark 버전이 올라감에 따라 Spark Streaming, Spark MLlib 등과 같이 Spark SQL도 하나의 프로젝트로 관리되고 있다. 홈페이지에는 각각 다른 프로젝트로 구분하고 있지만 편의상 나눈 것일 뿐, 실제로는 하나의 프로젝트안에 포함돼 있다.

성능 향상

![[그림 Ⅲ-2-37] 샤크와 Spark SQL의 성능 차이(테스트: Databricks)](https://dataonair.or.kr/publishing/img/dbguide/bigdata_technology/324_bigdata_20.png)

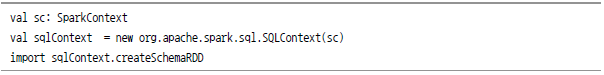

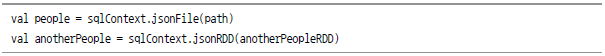

Adding SchemaRDD to RDDs

Spark SQL 실습

사용 언어와 실행방법

코드 실행방법은 맵리듀스처럼 코드를 작성하고 직접 빌드해 실행하는 방법도 있고, bin/spark-shell을 통해 아래 프로그램들을 인터랙티브하게 실행할 수도 있다. 그러나 셀 모드는 스칼라와 파이썬 버전만 가능하고 자바 버전은 지원하지 않는다.

SparkContext

RDDs

JSON 파일 읽기

하이브 데이터 읽어오기

캐싱

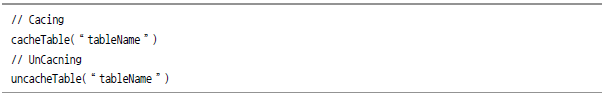

샘플 코드 보기

![// .. 아파치 라이선스 주석 생략 package org.apache.spark.example.sql import org.apache.spark.{SparkConf, SparkContext} import org.apache.spark.sql.SQLContext case class Record(key : Int, value: String) object RDDRealtion{def main(args: Array[String]){//SpakrCluster에 등록하기 위한 각종 정보 SparkConf val sparkConf = new SparkConf().setAppName("RDDRelation") // sparkconf를 이용해 SparkContext를 만들고 SparkContext를 SQLContext로 변환 val sc = new SparkContext(sparkConf) val sqlContext = new SQLContext(sc)](https://dataonair.or.kr/publishing/img/dbguide/bigdata_technology/324_bigdata_27.png)

하이브 대체 지원